je voulais changer le HDD1 qui hebergeait datavol1 car le SMart m'indique qu'il n'est pas en bonne santé

j'ai un second HDD avec un volume DATA, sur lequel j'ai beaucoup de fichier mais tout est sauvegardé.

j'ai éteint le NAS et retirer les Disque

j'ai insérer mon disque neuf en HDD1 et déclarer le volume Datavol1

j'ai recréer mes dossiers partagés. tout va bien. je redescend ma sauvegarde HDD1 en cemoment,

il faut aussi que je réinstalle mes applis.

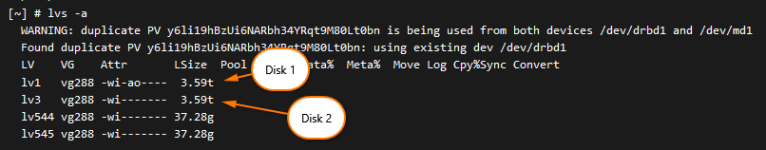

j'ai réinsérer le HDD2 avec le volume Data, mais il monte pas tout seul.

je voudrais tenter de monter le volume pour le récupérer avec toutes les données qui sont dessus (histoires d'éviter de jouer une restauration) qui va prendre beaucoup de temps,

Savez vous comment je peux re-declarer mon HDD2 avec le nom de volume DATA pour qu'il retrouve ses petits ? la partition s'appelle ev1partition3

ev1partition3

je me souviens qu'il y a quelques années, j'avais fair tune opération de réinsertion d'un disque après réinitialisation du QNAP et j'avais retrouvé mes données au recréant les dossier partagés avec les memes noms.

mais la c'est d'abord le volume que je veux remonter.

quand je mets le HDD2 en disque externe, le qnap voit bien plusieurs partition dont la plus grosse qu'il declare comme non initialisé

Auriez-vous une idée ?

merci.

j'ai un second HDD avec un volume DATA, sur lequel j'ai beaucoup de fichier mais tout est sauvegardé.

j'ai éteint le NAS et retirer les Disque

j'ai insérer mon disque neuf en HDD1 et déclarer le volume Datavol1

j'ai recréer mes dossiers partagés. tout va bien. je redescend ma sauvegarde HDD1 en cemoment,

il faut aussi que je réinstalle mes applis.

j'ai réinsérer le HDD2 avec le volume Data, mais il monte pas tout seul.

je voudrais tenter de monter le volume pour le récupérer avec toutes les données qui sont dessus (histoires d'éviter de jouer une restauration) qui va prendre beaucoup de temps,

Savez vous comment je peux re-declarer mon HDD2 avec le nom de volume DATA pour qu'il retrouve ses petits ? la partition s'appelle

je me souviens qu'il y a quelques années, j'avais fair tune opération de réinsertion d'un disque après réinitialisation du QNAP et j'avais retrouvé mes données au recréant les dossier partagés avec les memes noms.

mais la c'est d'abord le volume que je veux remonter.

quand je mets le HDD2 en disque externe, le qnap voit bien plusieurs partition dont la plus grosse qu'il declare comme non initialisé

Auriez-vous une idée ?

merci.