Bonsoir,

J'ai un QNAP 453D avec 4DD de 3To dedans. Suite à promo, je vais passer les 4DD de 3To à 4DD de 4To.

J'ai commencé le changement sur 2DD de 4To qui était dans un synology. J'ai donc enlevé un DD de 3To pour mettre directement un 4To.

Le NAS a lancé une reconstruction direct sur le 1er. Tout est nickel.

J'ai fait de même avec un second DD. Le système a lancé la reconstruction, nickel.

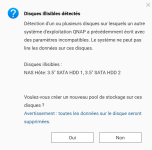

Par contre, j'ai à date un message d'alerte qui m'indique

Le souci, c'est que je n'arrive pas à faire quoique ce soit dans le paramétrage du NAS.

Les différentes interfaces ne permettent pas de cloturer le message par acceptation ou modifications, etc...

Idem je ne vois nulle par le To qui reste sur les 2 DD.

Je vais aller jusqu'au bout en changeant les DD un par un, mais y a t'il quelques choses que j'ai loupé?

D'avance merci.

J'ai un QNAP 453D avec 4DD de 3To dedans. Suite à promo, je vais passer les 4DD de 3To à 4DD de 4To.

J'ai commencé le changement sur 2DD de 4To qui était dans un synology. J'ai donc enlevé un DD de 3To pour mettre directement un 4To.

Le NAS a lancé une reconstruction direct sur le 1er. Tout est nickel.

J'ai fait de même avec un second DD. Le système a lancé la reconstruction, nickel.

Par contre, j'ai à date un message d'alerte qui m'indique

Le souci, c'est que je n'arrive pas à faire quoique ce soit dans le paramétrage du NAS.

Les différentes interfaces ne permettent pas de cloturer le message par acceptation ou modifications, etc...

Idem je ne vois nulle par le To qui reste sur les 2 DD.

Je vais aller jusqu'au bout en changeant les DD un par un, mais y a t'il quelques choses que j'ai loupé?

D'avance merci.