Wahhh, et beh, tu en as fait des choses ^^ et bonnes en plus de mon point de vue.

Ton pare-feu me semble bien configuré ^^

Ca me rassure un peu, je suis pas si nul que ça du coup ... LOL

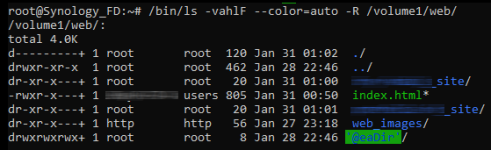

Avant de tenter l'accès en SSH, regarde les permissions du dossier web depuis FileStation.

... ...

J'avais déjà vérifié les permissions du groupe http via File Station et elles me semblaient correctes.

Je viens d'y retourner et voici un screen :

Le groupe http a l'accès en lecture et en écriture. Ca me semble bon en regardant dans File Station donc.

Du coup, ça devrait suffire pour accéder à tous les fichiers et sous-dossiers du répertoire "Web" non ? Bon bah, ça c'est ce qu'on vérifiera via connexion SSH comme l'a suggéré @cooper... Je suis en train d'activer le service SSH là (plus ou moins en même temps que je répond ici).

@cooper a raison, il y a quelque chose qui bloque l'accès.

Tu ne voudrais pas faire un petit index.html tout simple dans la racine de ce dossier ? Et le même dans un dossier que tu crées pour l'occasion.

Tu reconfigures tes virtualhost pour pointer sur la racine de /web/ pour l'un, et dans le dossier pour l'autre.

Et dis-moi si ça fonctionne ou pas.

C'est déjà comme ça que je teste l'accès à mes sites via leurs noms de domaines (avec un simple fichier index.html). J'en ai un directement dans le dossier Web et j'ai 2 autres fichiers index.html de test dans les 2 sous-dossiers où y'a mes sites web.

Et si ça ne fonctionne pas, désactive les redirections de port dans la Livebox pour le NAS, et désactive le pare-feu, et retente.

PS : et là je me dis, que cette dernière chose risque de ne pas fonctionner... car depuis ton LAN, en utilisant le nom de domaine, l'adresse IP que va voir le NAS ce sera celle de ta connexion internet... et la LB risque de ne pas aimer faire ça XD

Je trouvais très bizarre cette idée mais j'ai quand même tenté. Alors là (en enlevant les redirections de la Box et en désactivant le pare-feu), je n'ai plus l'erreur 403 certes mais je perds la protection du certif (plus de HTTPS et message qui dit "connexion non sécurisée bla bla bla"). Et si j'essaie de forcer l'accès non sécu, j'arrive pas à accéder au contenu, ça fait comme une erreur 404 (c'est pire là LOL).

Bref, test non concluant, j'ai remis les redirections de la box et réactivé le pare-feu!

On va passer à autre chose pour trouver une solution. j'espère que le test en SSH de @cooper donnera des indices ou une piste...

Dernière édition: