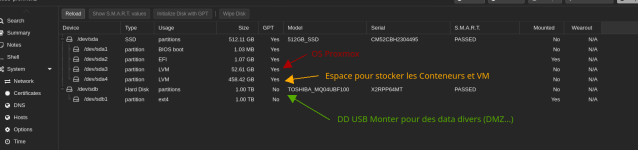

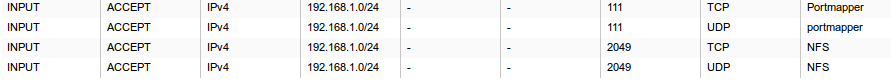

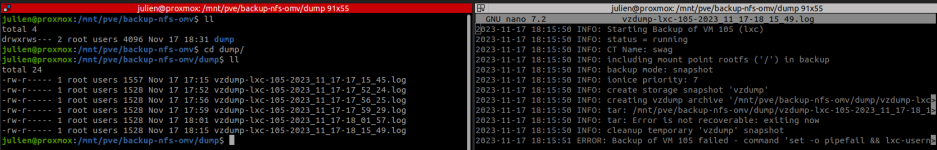

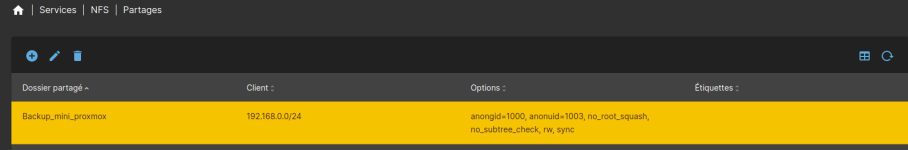

@Nincha Tes partages dans la VM OMV ont des BindMount venant de ton nœud proxmox ?

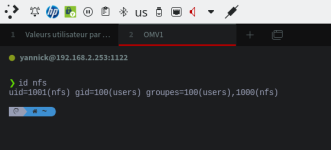

Si c'est le cas et que ton conteneur est "unpreviliged", il faut que tu change le propriétaire des répertoires et vérifier que les utilisateurs de tes conteneurs ont le même

uid.

Concrètement :

Sur le nœud Proxmox ou sont physiquement les partage : 100000:100000 est la base, ce qui correspond au root:root (0:0)

Si ton utilisateur a un

uid 1001 par exemple cote LXC pour tes partages, il faudra donc sur ton nœud Proxmox que le répertoire est comme propriétaire :

101001:101001 ce qui correspond à un répertoire 1001:1001 cote LXC ou VM.

En faite coté nœud proxmox les partages doivent avoir comme propriétaire 100000 + 'uid utilisateur'