Bonjour,

Habituellement lorsqu’un souci survient je me débrouille pour rétablir la situation mais là je sèche et un coup de main ne serait pas de trop.

LA CONFIG MATERIEL/OS :

Esprimo P956 I7-6700

2 SSD

3 sata de 1TO

ESXI 6.7 U2 + Pfsense sur le 1er SSD

W10 et OMV6 (à jour) sur second SSD

Les 3 sata sont déclarés chacun sur un datastore distinct afin de les « montrer » comme 3 disques à la VM OMV.

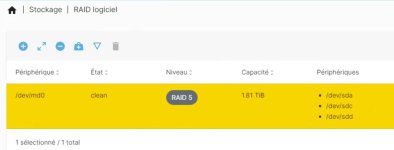

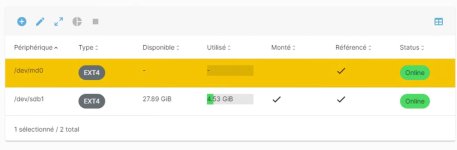

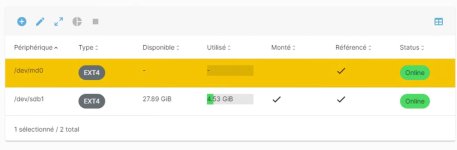

Ensuite sur l’OMV les disques sont montés en RAID5 et en ext4.

LE CONTEXTE DE LA PANNE

Vendredi fin d’am l’accès aux partages du raid5 sont inaccessibles, l’accès à l’interface Ngix pédale dans la semoule.

Un visu sur la console de l’ESXi indique que la VM est en attente de réponse car les datastores OMV1, 2 et 3 sont pleins.

Échec - Impossible d'effectuer cette opération actuellement car il y a une question en attente sur la machine virtuelle : 'msg.hbacommon.outofspace:There is no more space for virtual disk '/vmfs/volumes/63a2dc23-b8233340-21ba-001b21384264/OMV/OMV-000001.vmdk'.

Etrange car le volume disponible pour les datas est de 2 to et les données occupent moins de 700go….

J’ai cru comprendre que ce genre de souci peut provenir des snapshots. Il y en a effectivement un seul encours et selon moi il ne concernait que l’état du disque système.

Bref après suppression du snapshot et consolidation j’ai pu reprendre la main sur la vm et la relancer.

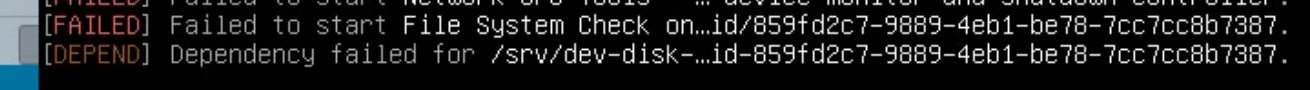

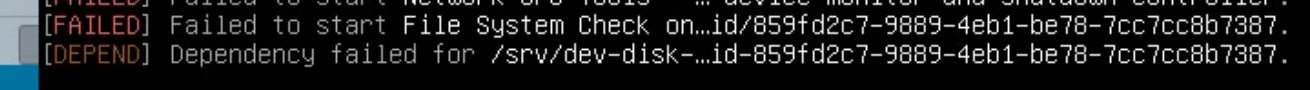

Mais au redémarrage j’ai un beau message d’erreur sur l'OMV :

Visiblement un souci de dépendance de services ???

Résultat le volume Raid ne se monte pas.

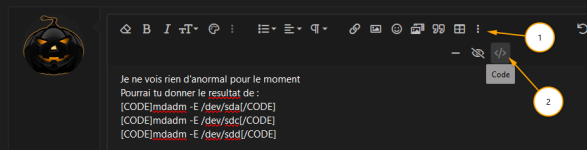

Pour autant l’état du raid semble sain et il est bien vu comme md0 ; hors il me semble avoir compris qu’il apparaît plutot comme md127 si un disque est manquant ?

J’ai accès au système via la console ou Putty/WinSCP sauf que je ne sais pas capable de déterminer la nature du défaut de montage.

La solution de facilité serait de formater le volume et de redescendre la sauvegarde de la veille mais le travail de la journée serait perdu et surtout j’aimerais bien en savoir plus sur les erreurs de montage de volumes.

Quelqu’un a-t-il une idée où des liens à me conseiller ?

Merci !

Habituellement lorsqu’un souci survient je me débrouille pour rétablir la situation mais là je sèche et un coup de main ne serait pas de trop.

LA CONFIG MATERIEL/OS :

Esprimo P956 I7-6700

2 SSD

3 sata de 1TO

ESXI 6.7 U2 + Pfsense sur le 1er SSD

W10 et OMV6 (à jour) sur second SSD

Les 3 sata sont déclarés chacun sur un datastore distinct afin de les « montrer » comme 3 disques à la VM OMV.

Ensuite sur l’OMV les disques sont montés en RAID5 et en ext4.

LE CONTEXTE DE LA PANNE

Vendredi fin d’am l’accès aux partages du raid5 sont inaccessibles, l’accès à l’interface Ngix pédale dans la semoule.

Un visu sur la console de l’ESXi indique que la VM est en attente de réponse car les datastores OMV1, 2 et 3 sont pleins.

Échec - Impossible d'effectuer cette opération actuellement car il y a une question en attente sur la machine virtuelle : 'msg.hbacommon.outofspace:There is no more space for virtual disk '/vmfs/volumes/63a2dc23-b8233340-21ba-001b21384264/OMV/OMV-000001.vmdk'.

Etrange car le volume disponible pour les datas est de 2 to et les données occupent moins de 700go….

J’ai cru comprendre que ce genre de souci peut provenir des snapshots. Il y en a effectivement un seul encours et selon moi il ne concernait que l’état du disque système.

Bref après suppression du snapshot et consolidation j’ai pu reprendre la main sur la vm et la relancer.

Mais au redémarrage j’ai un beau message d’erreur sur l'OMV :

Visiblement un souci de dépendance de services ???

Résultat le volume Raid ne se monte pas.

Pour autant l’état du raid semble sain et il est bien vu comme md0 ; hors il me semble avoir compris qu’il apparaît plutot comme md127 si un disque est manquant ?

J’ai accès au système via la console ou Putty/WinSCP sauf que je ne sais pas capable de déterminer la nature du défaut de montage.

La solution de facilité serait de formater le volume et de redescendre la sauvegarde de la veille mais le travail de la journée serait perdu et surtout j’aimerais bien en savoir plus sur les erreurs de montage de volumes.

Quelqu’un a-t-il une idée où des liens à me conseiller ?

Merci !