Bonjour,

@reinett Encore merci pour ton aide

Alors voici:

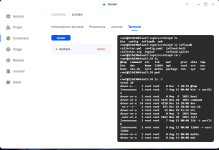

J'ai 1 HDD en Basic (Volume1) et 1 SSD en Basic également (Volume2).

Docker est installé sur le SSD donc Volume 2

Voici le journal:

s6-rc: info: service s6rc-oneshot-runner: starting

s6-rc: info: service s6rc-oneshot-runner successfully started

s6-rc: info: service fix-attrs: starting

s6-rc: info: service fix-attrs successfully started

s6-rc: info: service legacy-cont-init: starting

cont-init: info: running /etc/cont-init.d/01-timezone

cont-init: info: /etc/cont-init.d/01-timezone exited 0

cont-init: info: running /etc/cont-init.d/50-cron-config

cont-init: info: /etc/cont-init.d/50-cron-config exited 0

s6-rc: info: service legacy-cont-init successfully started

s6-rc: info: service legacy-services: starting

services-up: info: copying legacy longrun collector-once (no readiness notification)

services-up: info: copying legacy longrun cron (no readiness notification)

services-up: info: copying legacy longrun influxdb (no readiness notification)

services-up: info: copying legacy longrun scrutiny (no readiness notification)

s6-rc: info: service legacy-services successfully started

waiting for influxdb

starting cron

influxdb config file already exists. skipping.

starting influxdb

INFO: custom init already performed

influxdb not ready

ts=2025-12-15T09:35:47.886823Z lvl=info msg="Welcome to InfluxDB" log_id=0~pLhOgW000 version=v2.2.0 commit=a2f8538837 build_date=2022-04-06T17:36:40Z

ts=2025-12-15T09:35:47.887495Z lvl=info msg="Resources opened" log_id=0~pLhOgW000 service=bolt path=/opt/scrutiny/influxdb/influxd.bolt

ts=2025-12-15T09:35:47.887562Z lvl=info msg="Resources opened" log_id=0~pLhOgW000 service=sqlite path=/opt/scrutiny/influxdb/influxd.sqlite

ts=2025-12-15T09:35:47.889562Z lvl=info msg="Checking InfluxDB metadata for prior version." log_id=0~pLhOgW000 bolt_path=/opt/scrutiny/influxdb/influxd.bolt

ts=2025-12-15T09:35:47.889655Z lvl=info msg="Using data dir" log_id=0~pLhOgW000 service=storage-engine service=store path=/opt/scrutiny/influxdb/engine/data

ts=2025-12-15T09:35:47.889682Z lvl=info msg="Compaction settings" log_id=0~pLhOgW000 service=storage-engine service=store max_concurrent_compactions=2 throughput_bytes_per_second=50331648 throughput_bytes_per_second_burst=50331648

ts=2025-12-15T09:35:47.889695Z lvl=info msg="Open store (start)" log_id=0~pLhOgW000 service=storage-engine service=store op_name=tsdb_open op_event=start

ts=2025-12-15T09:35:47.889751Z lvl=info msg="Open store (end)" log_id=0~pLhOgW000 service=storage-engine service=store op_name=tsdb_open op_event=end op_elapsed=0.057ms

ts=2025-12-15T09:35:47.889787Z lvl=info msg="Starting retention policy enforcement service" log_id=0~pLhOgW000 service=retention check_interval=30m

ts=2025-12-15T09:35:47.889805Z lvl=info msg="Starting precreation service" log_id=0~pLhOgW000 service=shard-precreation check_interval=10m advance_period=30m

ts=2025-12-15T09:35:47.890413Z lvl=info msg="Starting query controller" log_id=0~pLhOgW000 service=storage-reads concurrency_quota=1024 initial_memory_bytes_quota_per_query=9223372036854775807 memory_bytes_quota_per_query=9223372036854775807 max_memory_bytes=0 queue_size=1024

ts=2025-12-15T09:35:47.893152Z lvl=info msg="Configuring InfluxQL statement executor (zeros indicate unlimited)." log_id=0~pLhOgW000 max_select_point=0 max_select_series=0 max_select_buckets=0

ts=2025-12-15T09:35:47.896492Z lvl=info msg=Listening log_id=0~pLhOgW000 service=tcp-listener transport=http addr=:8086 port=8086

starting scrutiny

2025/12/15 09:35:52 No configuration file found at /opt/scrutiny/config/scrutiny.yaml. Using Defaults.

___ ___ ____ __ __ ____ ____ _ _ _ _

/ __) / __)( _ \( )( )(_ _)(_ _)( \( )( \/ )

\__ \( (__ ) / )(__)( )( _)(_ ) ( \ /

(___/ \___)(_)\_)(______) (__) (____)(_)\_) (__)

github.com/AnalogJ/scrutiny dev-0.8.1

Start the scrutiny server

time="2025-12-15T09:35:52Z" level=info msg="Trying to connect to scrutiny sqlite db: /opt/scrutiny/config/scrutiny.db\n" type=web

time="2025-12-15T09:35:52Z" level=info msg="Successfully connected to scrutiny sqlite db: /opt/scrutiny/config/scrutiny.db\n" type=web

time="2025-12-15T09:35:52Z" level=info msg="InfluxDB certificate verification: true\n" type=web

time="2025-12-15T09:35:52Z" level=info msg="Database migration starting. Please wait, this process may take a long time...." type=web

time="2025-12-15T09:35:52Z" level=info msg="Database migration completed successfully" type=web

time="2025-12-15T09:35:52Z" level=info msg="SQLite global configuration migrations starting. Please wait...." type=web

time="2025-12-15T09:35:52Z" level=info msg="SQLite global configuration migrations completed successfully" type=web

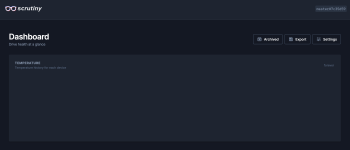

=>> quand je me connecte à l'interface web, ceci se rajoute dans le journal:

scrutiny | time="2025-12-15T09:47:10Z" level=info msg="172.28.0.1 - 69f126f82bd5 [15/Dec/2025:09:47:10 +0000] \"GET /web/dashboard\" 200 7467 \"\" \"Mozilla/5.0 (X11; Linux x86_64; rv:130.0) Gecko/20100101 Firefox/130.0\" (1ms)" clientIP=172.28.0.1 hostname=69f126f82bd5 latency=1 method=GET path=/web/dashboard referer= respLength=7467 statusCode=200 type=web userAgent="Mozilla/5.0 (X11; Linux x86_64; rv:130.0) Gecko/20100101 Firefox/130.

0"

scrutiny | time="2025-12-15T09:47:11Z" level=error msg="An error occurred while retrieving device summary not found: failed to initialize execute state: could not find bucket \"metrics\"" type=web

scrutiny | time="2025-12-15T09:47:11Z" level=error msg="172.28.0.1 - 69f126f82bd5 [15/Dec/2025:09:47:11 +0000] \"GET /api/summary\" 500 17 \"

http://192.168.0.253:6070/web/dashboard\" \"Mozilla/5.0 (X11; Linux x86_64; rv:130.0) Gecko/20100101 Firefox/130.0\" (26ms)" clientIP=172.28.0.1 hostname=69f126f82bd5 latency=26 method=GET path=/api/summary referer="

http://192.168.0.253:6070/web/dashboard" respLength=17 statusCode=500 type=web userAgent="Mozilla/5.0 (X11; Linux x86_64; rv:130.0) Gecko/20100101 Firefox/130.0"

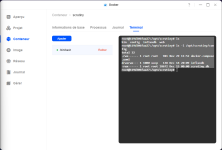

Je pense que tu as vu juste au niveau des droits. J'ai essayé (je ne suis pas doué dans un terminal) de faire les commandes comme sur tes screenshot:

As-tu besoin d'autres infos?