Hello

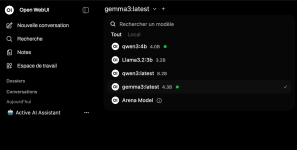

Afin d’utiliser des modeles IA en évitant de mettre des infos perso sur leurs serveurs, j’ai installé Ollama avec 2 modèles IA en local sur mon DXP4800+.

A noter que j'ai bodybuildé le NAS depuis le début avec les 64Go de RAM.

Il me reste à sensibiliser ma wife et mes filles à la sensibilisation du partage de nos/leurs infos perso, mais aussi à l'utilisation de cette IA locale.

J'étais parti dans l'idée de faire tourner ca sur un Pi5 16G, et je suis tombé sur ce lien Comment exécuter Ollama et les modèles de langage sur le Raspberry Pi 5 : guide complet. Finalement sans interface web, ca ne va pas le faire ! Dans ce meme post, l'auteur parle aussi de docker et Ollama , webUI.

De fil en aiguille, apres avoir ouvert Site Officiel OIlama, Depot Ollama Github, et WebUI sur GitHub pour Pi5, j'ai finalement trouvé des sites plus parlant ci dessous :

- Ollama Models Setup: Step-by-Step Guide with Docker Compose

- Ollama et Open WebUI : déploiement local de LLM avec Docker

- How to locally deploy ollama and Open-WebUI with Docker Compose

- Setting Up Ollama with Open-WebUI: A Docker Compose Guide

- How to setup Open WebUI with Ollama and Docker Desktop

J'ai du aussi me remettre sur Portainer, et comme je ne l'utilise que rarement, je me suis souvenu de Marius Hosting et ses tutos, plutot bien ou meme tres biens foutus.

How to Install Ollama on Your Synology NAS, m'a aussi bcp aidé, mais la partie reverse proxy, je la ferai après via Nginx Proxy manager.

j'ai donc créé les répertoires dans mon dossier partagé Docker, soit pour moi :

/volume2/docker/ollama/ollama/

/volume2/docker/ollama/modelfiles

/volume2/docker/ollama/openwebui

En jouant les David Guetta en mixant les docker-compose donnés dans les différents sites, et bien sur en adaptant à mon environnement après avoir compris à minima les différentes lignes, j'en suis arrivé à un truc qui fonctionne chez moi c'est sur, mais en distant, j'attends le retour des mes filles qui , disons le simplement, ont l'air de s'en foutre velu ! , surtout un dimanche après midi en pleine sieste en meme temps que leurs mouflets.

, surtout un dimanche après midi en pleine sieste en meme temps que leurs mouflets.

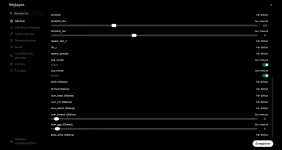

Mon docker-compose est le suivant et bien évidemment à parfaire en y ajoutant, car j'ai vu aussi qu'il etait possible de mettre des parametres jouant sur l'allocation des ressources :

Afin d’utiliser des modeles IA en évitant de mettre des infos perso sur leurs serveurs, j’ai installé Ollama avec 2 modèles IA en local sur mon DXP4800+.

A noter que j'ai bodybuildé le NAS depuis le début avec les 64Go de RAM.

Il me reste à sensibiliser ma wife et mes filles à la sensibilisation du partage de nos/leurs infos perso, mais aussi à l'utilisation de cette IA locale.

J'étais parti dans l'idée de faire tourner ca sur un Pi5 16G, et je suis tombé sur ce lien Comment exécuter Ollama et les modèles de langage sur le Raspberry Pi 5 : guide complet. Finalement sans interface web, ca ne va pas le faire ! Dans ce meme post, l'auteur parle aussi de docker et Ollama , webUI.

De fil en aiguille, apres avoir ouvert Site Officiel OIlama, Depot Ollama Github, et WebUI sur GitHub pour Pi5, j'ai finalement trouvé des sites plus parlant ci dessous :

- Ollama Models Setup: Step-by-Step Guide with Docker Compose

- Ollama et Open WebUI : déploiement local de LLM avec Docker

- How to locally deploy ollama and Open-WebUI with Docker Compose

- Setting Up Ollama with Open-WebUI: A Docker Compose Guide

- How to setup Open WebUI with Ollama and Docker Desktop

J'ai du aussi me remettre sur Portainer, et comme je ne l'utilise que rarement, je me suis souvenu de Marius Hosting et ses tutos, plutot bien ou meme tres biens foutus.

How to Install Ollama on Your Synology NAS, m'a aussi bcp aidé, mais la partie reverse proxy, je la ferai après via Nginx Proxy manager.

j'ai donc créé les répertoires dans mon dossier partagé Docker, soit pour moi :

/volume2/docker/ollama/ollama/

/volume2/docker/ollama/modelfiles

/volume2/docker/ollama/openwebui

En jouant les David Guetta en mixant les docker-compose donnés dans les différents sites, et bien sur en adaptant à mon environnement après avoir compris à minima les différentes lignes, j'en suis arrivé à un truc qui fonctionne chez moi c'est sur, mais en distant, j'attends le retour des mes filles qui , disons le simplement, ont l'air de s'en foutre velu !

Mon docker-compose est le suivant et bien évidemment à parfaire en y ajoutant, car j'ai vu aussi qu'il etait possible de mettre des parametres jouant sur l'allocation des ressources :

Code:

services:

ollama:

image: ollama/ollama:latest #Marius dit de prendre l'image ollama/ollama:rocm preferable pour CPU AMD, ce qui est le cas normalement sur ce NAS, mais ca fonctionne.

container_name: ollama

ports:

- "11434:11434"

volumes:

- /volume2/docker/ollama/ollama:/root/.ollama #repertoires dans dossier partagé Docker

- /volume2/docker/ollama/modelfiles:/modelfiles #repertoires dans dossier partagé Docker

environment:

- OLLAMA_NUM_PARALLEL=2 #nombre de requêtes que j'ai choisi de mettre en // 2 sachant que je me dis plus y'en a, moins ca sera rapide, j'adapterai si besoin

- OLLAMA_MAX_LOADED_MODELS=1 #nombre de modele pouvant etre chargé en meme temps.

restart: unless-stopped

ollama-pull: # pour télécharger les modèles IA indiqués plus bas soit ici llama3.2:3b et qwen2.5:7b pour moi.

image: ollama/ollama:latest

container_name: ollama-pull

depends_on:

- ollama

environment:

- OLLAMA_HOST=http://ollama:11434

volumes:

- /volume2/docker/ollama/ollama:/root/.ollama

entrypoint: ["/bin/sh","-lc"]

command: >

"set -e;

echo 'Waiting for Ollama...';

until ollama list >/dev/null 2>&1; do sleep 2; done;

echo 'Pulling models...';

ollama pull llama3.2:3b; # modele IA qui sera téléchargé , liste sur modele IA que l'on trouve ici => https://ollama.com/search

ollama pull qwen2.5:7b; # modele IA qui sera téléchargé , modele IA que l'on trouve ici => https://ollama.com/search ; donc 2 modele en ligne avec OLLAMA_NUM_PARALLEL=2

echo 'models pulled'"

restart: "no"

webui: # Lles puristes noteront que j'aurai du appeler ce service openwebui vu la ligne du dessous

image: ghcr.io/open-webui/open-webui:main # j'étais parti sur WebUI mais j'ai pris OpeWebUi trouvé sur l'un des sites ci dessus ; pourquoi ? j'sais plus !

container_name: open-webui

ports:

- "3001:8080" # normalement, c'est putot le 3000 mai sedia occupé chez moi par Grafana

depends_on:

- ollama

environment:

- OLLAMA_BASE_URL=http://ollama:11434

- WEBUI_AUTH=true

- WEBUI_ALLOW_SIGNUP=true #permet de creed son user

- WEBUI_SECRET_KEY=dOxZYTTZgXKMHkqLBIQVImayQXAVWdzGBPuFJKggzcgvgPJPXpWzqzKaUOIOGGIr #j'ai repris celle de Marius

volumes:

- /volume2/docker/ollama/openwebui:/app/backend/data

restart: unless-stopped

Dernière édition: