GitHub - 007revad/Synology_HDD_db: Add your HDD, SSD and NVMe drives to your Synology's compatible drive database and a lot more

Add your HDD, SSD and NVMe drives to your Synology's compatible drive database and a lot more - 007revad/Synology_HDD_db

Bonjour,

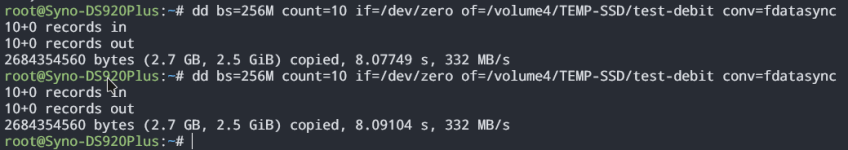

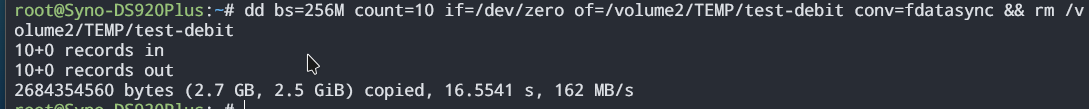

J'ai bien envie d'essayer de faire un volume de stockage sur un SSD NVMe M2 qui normalement devrait être dédié au cache SSD.

Je sais qu'il va y avoir de la bricole à faire d'un point de vue ligne de commande, et que ça risque de ne pas être pérenne dans le temps. Mais j'en ai conscience, et j'en accepte les risques.

Je modifierais ici les commandes à rentrer pour en faire un volume quand je les aurais, et que je les aurais essayé.

1/ Mais tout d'abord, quel SSD acheter ?

Je ne voudrais pas cramer trop de thunes là dedans, surtout pour un projet tel que celui-là...

Aussi j'ai repéré ces SSD 512Go à presque 50€ :

- https://www.amazon.fr/gp/product/B093CN3P9V/ref=ox_sc_act_title_1?smid=A1X6FK5RDHNB96&th=1

- https://www.amazon.fr/Crucial-CT500P2SSD8-Interne-Vitesses-atteignant/dp/B086BGWNY8?th=1

Qu'en pensez-vous ?

2/ Ensuite, les commandes... Faut que je retrouve le sujet où on en a parlé sur ce forum, mais si d'ici à ce que j'ai trouvé, quelqu'un veut bien poster à la suite la méthode, je suis preneur ^^ (Il sera probablement plus rapide que moi

Merci d'avance

++

Miles

Dernière édition: