Bonjour,

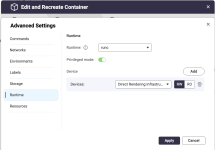

Je souhaitais savoir si certains d'entre vous avaient déjà tenté l'expérience d'installer avec Docker Ollama sur son Nas ainsi que Open Web Ui qui apporte un enviro type ChatGPT en local.

J'ai moi même installé Ollama + Open WebUi sur mon 253D car ils sont très simples à configurer mais Ollama n'utilise pas le GPU intel de mon Nas et meme avec un Model minimaliste type Phil3 ça rame. J'ai vu qu'il existe un projet Ipex-LLM qui permet à Ollama d'utiliser le GPU intel mais par contre je ne comprends rien à la 'installation, donc si qqun a déjà tenté l'aventure je suis preneur de ses conseils.

Merci.

Je souhaitais savoir si certains d'entre vous avaient déjà tenté l'expérience d'installer avec Docker Ollama sur son Nas ainsi que Open Web Ui qui apporte un enviro type ChatGPT en local.

J'ai moi même installé Ollama + Open WebUi sur mon 253D car ils sont très simples à configurer mais Ollama n'utilise pas le GPU intel de mon Nas et meme avec un Model minimaliste type Phil3 ça rame. J'ai vu qu'il existe un projet Ipex-LLM qui permet à Ollama d'utiliser le GPU intel mais par contre je ne comprends rien à la 'installation, donc si qqun a déjà tenté l'aventure je suis preneur de ses conseils.

Merci.