Bonjour,

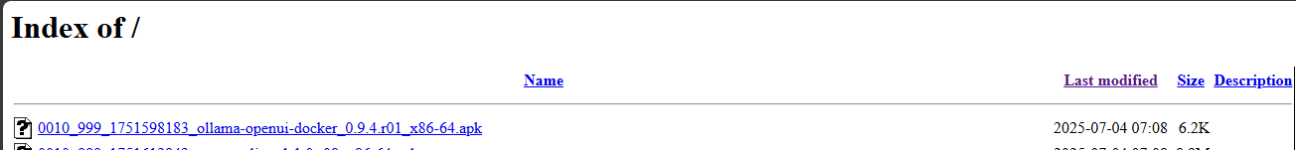

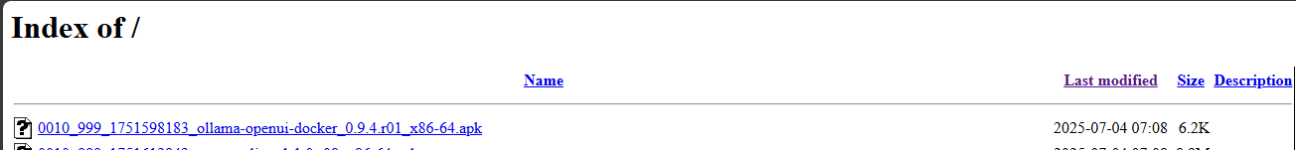

Je viens de voir que l'application OLLAMA a été construite et disponible pour Asustor.

www.asustor.com

www.asustor.com

Image Docker: LLM + Webui

post-uninstall.sh:

Je viens de voir que l'application OLLAMA a été construite et disponible pour Asustor.

ASUSTOR NAS - Ollama + Open WebUI

Ollama facilite la mise en œuvre locale de modèles de langage volumineux.<br /> Open WebUI est une plateforme d'IA auto-hébergée, extensible, riche en fonctionnalités et conviviale, conçue pour fonctionner entièrement hors ligne. Elle prend en charge divers exécuteurs LLM comme Ollama et les API...

Image Docker: LLM + Webui

ollama/ollama:latest

ghcr.io/open-webui/open-webui:latest

Bash:

docker run -d --name OllamaCCC -p 11434:11434 -v /share/Docker/Ollama_OpenWebUI/ollama:/root/.ollama:rw --restart always ollama/ollama:latest

docker run -d --name OpenWebUI -p 30000:8080 -e OLLAMA_BASE_URL=http://${NAS_HOST_IP}:11434 -v /share/Docker/Ollama_OpenWebUI/open-webui:/app/backend/data:rw --restart always ghcr.io/open-webui/open-webui:latestpost-uninstall.sh:

Dernière édition: